삼성, ‘엔비디아 반드시 뚫어라’ 올해 전 세계 AI용 웨이퍼 77% 독점

미국 반도체 설계. 제조업체인 엔비디아(NVIDIA)가 올해 GPU 게임, 프로페셔널 그래픽 카드, GPU AI 가속기용 AI 웨이퍼 사용량이 70%를 넘어설 것으로 전망됐다.

모건 스탠리의 최신 분석 보고서에 따르면, 엔비디아는 지난 2024년 생산된 전 세계 AI용 반도체 칩 웨이퍼의 51%를 사용했으며 올해는 이 비율이 77%에 달할 것으로 전망됐다.

지난해 AI용 반도체 칩 사용량은 엔비디아 외에 구글이 19%, 아마존 AWS 10%, AMD 9%, 테슬라 5%, 중국 제조업체 3%, 마이크로소프트(MS)가 2.1%였다.

보고서는 올해는 엔비디아로의 쏠림이 심화되면서 나머지 기업들이 더욱 위축돼 구글이 10%, 아마존 AWS가 7%, AMD가 3%로 하락하고 미국의 강력한 제재를 받고 있는 중국 제조업체의 점유율은 거의 없을 것으로 예상했다.

또, 올해 전 세계적으로 AI 칩을 생산하는 데 사용되는 300mm 표준 웨이퍼 수는 70만9,000개에 이를 것으로 추산되며, 총 가치는 약 145억 7000만 달러(20조9,560억 원)에 이를 것으로 예상됐다.

이 가운데 엔비디아는 53만5,000개를 소비할 예정이며, 단가는 약 20,900달러(3,006만 원)로 총 비용은 112억 달러(16조1,089억 원)에 달할 것으로 예상됐다.

제품별로는 H100과 H200은 각각 2만 개 및 10만 개의 웨이퍼를 소모하고, B200은 22만 개, 차세대 B300은 12만5,000개의 웨이퍼가 필요할 것으로 예상됐다.

또, AMD는 약 50만 개의 웨이퍼가 필요하며, 비용은 14억 달러(2조136억 원) 이상에 이를 것으로 예상됐다. 그 중 MI300과 MI325는 총 2만5,000개, 단가는 2만5,200달러, 차세대 MI355는 2만5,000개, 단가는 3만2,000달러로 예상했다.

중국 제조업체들은 첨단 AI용 웨이퍼 사용에 제한을 받고 있으며 최대 7nm 웨이퍼(개당 1만9천달러) 5,500개를 사용할 것으로 전망됐다.

한편, 한화증권투자보고서에 따르면 삼성전자와 SK하이닉스 양 사의 올해 고대역폭메모리(HBM) 출하량이 203억 기가비트(Gb)로 추정됐다. 이는 전년 대비 101%가 증가한 것이다.

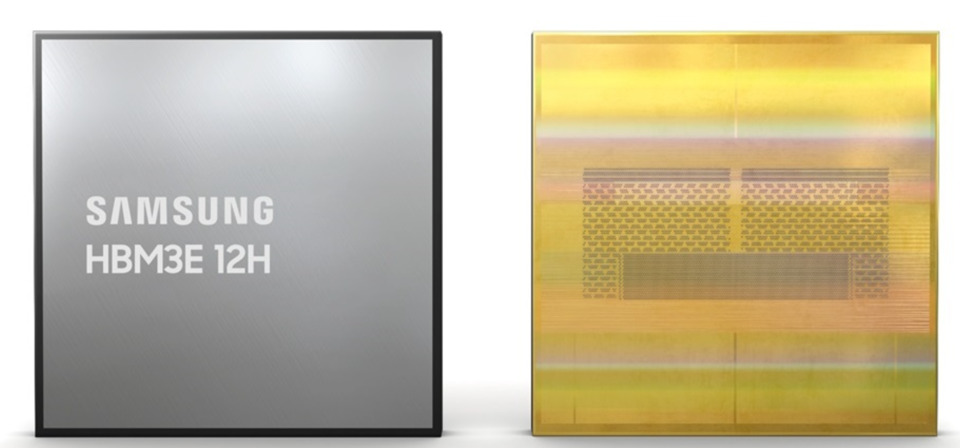

앞서 블룸버그 통신은 삼성이 엔비디아와 중국 특화 인공지능(AI) 가속기 칩에 탑재될 HBM3E 8단 메모리를 공급하기로 합의했다고 보도했다.

삼성은 HBM3E 8단 제품을 이르면 1분기 말부터 엔비디아에 공급할 예정이지만 초기 물량은 극히 미미한 것으로 알려졌다. 때문에 엔비디아의 HBM3E 12단과 6세대 HBM4 공급 여부가 올해 HBM시장에서의 승패를 좌우할 것으로 예상된다.

댓글 없음